Comment les cybercriminels utilisent l’IA pour contourner les systèmes de sécurité ?

Sommaire

- 1. Pourquoi l’IA attire les cybercriminels ?

- 2. 5 méthodes concrètes utilisées par les cybercriminels

- 2.1. 1. Phishing conversationnel par IA

- 2.2. 2. Deepfakes vocaux ou vidéos

- 3. Top 5 des usages actuels de l’IA par les cybercriminels

- 3.1. 3. Malwares auto-apprenants

- 3.2. 4. Reconnaissance automatisée de failles

- 3.3. 5. Bots IA sur les réseaux sociaux

- 4. Quelles menaces pour les entreprises et les citoyens ?

- 5. L’IA défensive peut-elle répondre à l’IA malveillante ?

- 5.1. Domaines d’application de l’IA défensive :

- 6. Former les futurs experts experts en cybersécurité avec CSB.SCHOOL

L’intelligence artificielle (IA) transforme tous les secteurs, y compris… celui de la cybercriminalité. L’explosion des outils d’IA générative accessibles au grand public – comme ChatGPT, DALL·E ou ElevenLabs – a également fourni aux cybercriminels de nouveaux moyens pour déjouer les défenses traditionnelles. Grâce à l’IA, les attaques deviennent plus précises, plus rapides, plus difficiles à détecter. Deepfakes vocaux, phishing conversationnel, malware intelligent : la frontière entre réalité et manipulation numérique s’estompe dangereusement.

Pourquoi l’IA attire les cybercriminels ?

L’intelligence artificielle et la cybersécurité forment désormais un champ d’affrontement permanent entre acteurs défensifs et offensifs.

Voici pourquoi l’IA est devenue un atout majeur pour les cybercriminels :

-

Automatisation massive : L’IA permet d’industrialiser des campagnes de phishing, de créer des malwares polymorphes ou d’analyser des cibles à grande échelle.

-

Production de contenus réalistes : Voix synthétiques, deepfakes vidéos, textes parfaits dans toutes les langues… les attaques gagnent en crédibilité.

-

Confusion entre humains et IA : Difficile pour une entreprise de distinguer un interlocuteur humain d’un chatbot malveillant.

-

Accessibilité et faible coût : Des modèles pré-entraînés open source, des API abordables, des outils en ligne gratuits… l’entrée dans la cybercriminalité automatisée n’a jamais été aussi simple.

5 méthodes concrètes utilisées par les cybercriminels

1. Phishing conversationnel par IA

Grâce aux modèles linguistiques, les e-mails de phishing deviennent fluides, crédibles, contextualisés. Mieux encore, certains intègrent des dialogues en temps réel (via chatbots) pour piéger l’utilisateur.

Un e-mail imitant parfaitement le ton d’un collègue RH, personnalisé selon les données LinkedIn.

Réponses automatiques aux doutes de la victime via un agent conversationnel.

Phishing traditionnel vs Phishing généré par IA

| Critère | Phishing traditionnel | Phishing généré par IA |

|---|---|---|

| Qualité linguistique | Souvent maladroite, fautes d’orthographe | Texte fluide, multilingue, syntaxe naturelle |

| Personnalisation | Générique (ex : « Cher client ») | Adapté à la cible (nom, fonction, historique de contact) |

| Volume d’envoi | Massif, non ciblé | Automatisé mais ultra ciblé, parfois en temps réel |

| Canal utilisé | E-mail principalement | Multicanal : e-mail, messagerie instantanée, réseaux sociaux |

| Apparence visuelle | Design approximatif ou obsolète | Copie parfaite de l’identité visuelle de l’entreprise ciblée |

| Interaction utilisateur | Lien malveillant simple | Dialogue dynamique avec chatbot, réponse adaptative |

| Taux de détection | Élevé (par filtres antispam classiques) | Faible (passe les filtres grâce à l’originalité et au contexte) |

2. Deepfakes vocaux ou vidéos

Les deepfakes permettent d’usurper une identité à des fins de fraude ou de manipulation. Des voix synthétiques imitant un PDG peuvent convaincre un comptable d’un virement urgent.

En 2023, une entreprise britannique a été victime d’une fraude sophistiquée utilisant l’intelligence artificielle. Les cybercriminels ont généré un deepfake vocal imitant parfaitement la voix du directeur financier, demandant un virement urgent à un partenaire étranger. Trompé par la crédibilité de l’appel, un cadre a exécuté la transaction sans se douter de la supercherie. Résultat : une perte directe de 250 000 €, sans possibilité de récupération.

Top 5 des usages actuels de l’IA par les cybercriminels

- Création de faux profils LinkedIn avec images IA

- Génération de malware polymorphe

- Clonage vocal pour fraudes bancaires

- Scraping de données via IA

- Génération automatique de spear phishing

3. Malwares auto-apprenants

Les malware intelligents utilisent l’IA pour échapper à la détection. Ils peuvent modifier leur signature, analyser leur environnement, désactiver les antivirus ou se dissimuler dans des fichiers inoffensifs.

Concept : malware évolutif selon les réponses du système cible, quasi-impossible à contenir avec des règles statiques.

4. Reconnaissance automatisée de failles

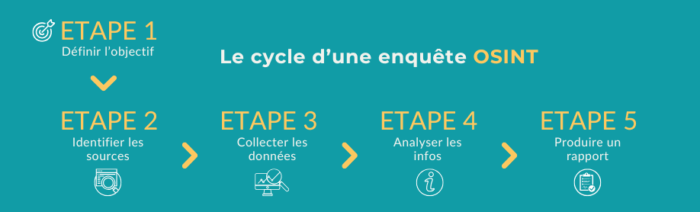

Les cybercriminels déploient des IA capables de scanner le web et les applications à la recherche de vulnérabilités exploitables (OSINT, ports ouverts, failles logicielles).

Résultat : des attaques ciblées, menées en quelques minutes après détection.

5. Bots IA sur les réseaux sociaux

Sur X, LinkedIn ou Facebook, des bots alimentés par IA interagissent avec les utilisateurs pour capter des données, manipuler l’opinion, ou effectuer de l’ingénierie sociale ciblée.

Objectif : bâtir une relation de confiance avant le passage à l’acte (exfiltration, escroquerie, harponnage).

Quelles menaces pour les entreprises et les citoyens ?

L’essor de l’IA offensive redéfinit les menaces cyber. Face à des attaques toujours plus crédibles, les risques s’intensifient :

-

Contenus indétectables : les e-mails frauduleux ou deepfakes échappent aux filtres classiques.

-

Crise de confiance : une vidéo falsifiée ou un message vocal truqué peut déstabiliser un service entier.

-

Attaques ciblées à grande échelle : la personnalisation IA rend chaque attaque plus percutante.

-

Vulnérabilité accrue des PME : peu équipées pour faire face à des assauts automatisés et sophistiqués.

L’IA défensive peut-elle répondre à l’IA malveillante ?

Heureusement, l’intelligence artificielle et cybersécurité ne riment pas uniquement avec menace. Elle est aussi un levier puissant de défense :

Domaines d’application de l’IA défensive :

-

Détection comportementale : repérer une anomalie d’usage ou un changement suspect dans les connexions.

-

SIEM et EDR augmentés : les outils comme Splunk utilisent des algorithmes IA pour trier et corréler les événements critiques.

-

Réponse automatisée : déclencher une isolation réseau dès qu’un malware est repéré.

-

Filtrage intelligent de contenu : analyse contextuelle d’un e-mail, même sans signature connue.

IA défensive VS IA offensive

| Domaine | Usages offensifs (IA des cybercriminels) | Usages défensifs (IA en cybersécurité) |

|---|---|---|

| Phishing | Génération d’e-mails personnalisés, multilingues et crédibles | Détection contextuelle des messages suspects via NLP |

| Deepfake (voix/vidéo) | Usurpation d’identité pour fraudes ou manipulations | Analyse biométrique, détection de falsifications audiovisuelles |

| Reconnaissance & ciblage | Scan automatisé de vulnérabilités, profils sociaux, mots de passe faibles | IA pour corréler les journaux, prioriser les alertes de vulnérabilité |

| Malware | Malware auto-adaptatif, polymorphe, furtif | Détection comportementale et sandboxing dynamique |

| Ingénierie sociale | Bots IA interagissant sur les réseaux sociaux pour manipuler | Supervision d’activité anormale, analyse de sentiment conversationnel |

| Automatisation des attaques | Campagnes de phishing ou ransomware à grande échelle | Réponse automatique aux incidents, neutralisation proactive |

Attention cependant : l’IA défensive ne remplace pas l’humain. C’est un binôme IA + analyste qui permet une réponse efficace, adaptative et éthique.

Former les futurs experts experts en cybersécurité avec CSB.SCHOOL

Notre école de cybersécurité forme les spécialistes de demain grâce à des parcours complets, accessibles dès le niveau post-bac jusqu’au Bac+5, spécifiquement orientés cybersécurité. Les programmes conçus avec des experts et nos formations labellisées SecNumEdu (par l’ANSSI) ainsi que par la Région Auvergne-Rhône-Alpes attestent de notre engagement en matière de qualité et de rigueur pédagogique. CSB.SCHOOL est actuellement la seule école à bénéficier de ces deux reconnaissances dans le domaine de la cybersécurité.

Continuez votre lecture

Réussir son entretien d’admission en école de cybersécurité | Guide complet 2026

Journées de la Cyber 2026 : passer du questionnaire Excel à une véritable stratégie de gestion du risque tiers